0. 목차

- 컴퓨터는 뇌가 될 수 있을까?

- 생각하는 기계는 결코 만들 수 없다?

- 지능에 대한 정의

- AI 연구의 가장 큰 목표는 '범용 AI'

- 지능의 특성

1. 컴퓨터는 뇌가 될 수 있을까?

컴퓨터의 능력은 궁극적으로 얼마나 확장될 수 있을까? 인간의 뇌도 컴퓨터의 한 형태로 간주할 수 있을까? 20세기 중반 컴퓨터의 시대가 도래하자 이 두 가지 질문을 둘러싼 논쟁이 시작되었다. 첫 번째 질문의 경우, 처음에는 컴퓨터와 뇌가 기본적으로 똑같은 정보처리장치라고 보는 시각이 우세했으나, 이후 근본적으로 다르다는 시각이 더 우세해졌다. 뇌는 컴퓨터의 일종일까?

1-1. '기존 컴퓨터의 지능'과 '인간의 지능'은 정반대로 진화한다.

1940년대 컴퓨터가 처음으로 대중적인 관심사로 떠올랐을 때, 사람들은 컴퓨터를 '생각하는 기계'라고 인식했다. 언론은 1946년 발표한 '에니악(ENIAC)'을 '거대뇌(Giant Brain)'라고 묘사했다. 1950년대에 컴퓨터가 상품화되면서 나온 광고들은 대게, 컴퓨터를 평범한 생물학적 뇌가 결코 따라할 수 없는 묘기를 부리는 뇌라고 광고했다. 이 기계가 이러한 선전에 걸맞은 능력을 갖출 수 있었던 것은 컴퓨터 프로그램 때문이다. 1959년 카네기멜론대학의 '허버트 사이먼(Herbert A. Simon)', '쇼(J. C. Shaw)', '앨런 뉴웰(Allen Newell)'이 만든 '일반 문제 해결자(General Problem Solver)'는 수학자 '버트란드 러셀(Bertrand Russell, 1872~1970)'과 '알프레드 노스 화이트헤드(Alfred North Whitehead, 1861~1947)'가 1913년 출간한 '수학 원리(Principia Mathematica)'에서 풀지 못한 정리를 증명하는 데 성공했다. 이후 컴퓨터는 계속 발전하여 수학 문제를 풀거나 질병을 진단하거나 체스를 두는 것과 같은 지적인 행위에서 인간보다 훨씬 뛰어난 능력을 보인다는 것을 입증했다.

한편, 컴퓨터가 운동화 끈을 매는 로봇을 제어하지 못하고, 다섯 살짜리 아이도 이해하는 일상적인 언어를 이해하지 못한다는 사실도 분명해졌다. 그렇다면, 컴퓨터는 뇌가 될 수 없을까? 하지만 이러한 기술은 이제 컴퓨터가 습득하기 시작하는 단계에 있을 뿐 불가능한 것은 아니다. 재미있는 사실은, 컴퓨터 지능은 인간의 두뇌가 성숙하는 방향과 정반대로 진화한다는 것이다.

1-2. 컴퓨터도 뇌가 될 수 있다.

그러면 '뇌(Brain)는 '컴퓨터(Computer)'가 아닐까? 하지만 이러한 생각은 '사과소스는 사과가 아니다'라고 말하는 것과 별반 다를 것이 없다. 기술적으로 이러한 진술은 '참'이지만, 사과로 사과소스를 만들 수 있다는 것은 누구나 안다.

문제는 컴퓨터가 인간의 뇌와 동일한 기능을 수행할 수 있도록 만드는 알고리즘을 찾아낼 수 있느냐 하는 것이다. 어쨌든 컴퓨터에는 '보편성'이 있기 때문에 알고리즘을 찾아내기만 하면 작동할 수 있다. 여기서 말하는 '보편성'이란 하드웨어 성능의 제약 안에서는 어떤 알고리즘이든 작동할 수 있는 컴퓨터의 특성을 말한다. 반면, 인간의 뇌는 일단의 특정한 알고리즘만 운용한다. 상당한 가소성과 더불어 경험에 기반하여 '신경망(Neural Network)'을 재구축할 수 있다는 점에서 매우 영리한 기관이기는 하지만, 어쨌든 이러한 기능은 모두 소프트웨어를 통해 모방할 수 있다.

2. 생각하는 기계는 결코 만들 수 없다?

2-1. '존 설'의 '중국어 방 테스트'

일부 철학자들과 신학자들은 인간처럼 생각하는 기계는 결코 만들 수 없다고 주장한다. '캘리포니아대학교 버클리(University of California, Berkeley)'의 철학자 '존 설(John Searle, 1932~)'은 인공지능이 불가능하다는 것을 증명하기 위해 '중국어 방 테스트(Chinese Room Test)'를 고안했다. '존 설'은 로봇이 특정한 방식의 튜링 테스트를 통과했다고 해도, 그것은 주어진 규칙에 따라 기호를 다룬 결과일 뿐, 아무런 이해도 수반되지 않는다고 주장했다.

당신이 상자 안에 들어가 있다고 하자. 이제 누군가가 당신에게 중국어로 질문을 해올 것이다. 당신은 중국어를 한 마디도 알아듣지 못하지만, 중국어를 당신에게 친숙한 언어로 번역해 주는 고성능 전자사전을 갖고 있다. 그러면 당신은 중국어를 전혀 이해하지 못한 채 상자 밖의 인물과 대화를 나눌 수 있다. 인공지능에 대한 '존 설'의 비판은 '문법(Syntax)'과 '의미(Semantics)'의 차이로 요약된다. 로봇은 한 언어를 '문법적(문장과 구조 등)'으로 이해할 수는 있지만, '의미론적(단어의 의미)'으로는 아무것도 이해하지 못한다.

2-2. '양자적 효과' 때문에 인공지능은 불가능하다?

대부분의 컴퓨터과학자들은 여러 개의 '트랜지스터(Transistor)'를 연결하면 두뇌의 모든 '뉴런(Neuron)'을 재현할 수 있다고 본다. 두뇌의 구조가 매우 복잡하긴 하지만, 근본적으로는 트랜지스터로 재현할 수 있는 뉴런의 집합에 불과하다는 것이다.

하지만 2020년에 노벨물리학상을 수상한 '로저 펜로즈(Roger Penrose, 1931~)'는 이 의견에 반대하였다. 그는 '인간처럼 생각하고 의식을 갖는 기계를 만들 수 없는 이유로 '양자론(Quantum Theory)'을 내세웠 있다. 그는 인간의 두뇌에 양자적 효과가 작용하기 때문에 인간이 생각하는 것이 가능하다고 주장했다. 구체적으로는 뇌세포 안에 있는 '미세소관(Microtubules)'이 양자적 효과를 발휘하여 사고가 진행되기 때문에, 단순한 전자 부품으로는 인간의 두뇌를 흉내 낼 수 없다는 것이다. 그는 '쿠르크 괴델(Kurt Godel)'의 '불완전성 정리(Incompleteness Theorem)'가 산술학의 불완전함을 입증한 것처럼, 하이젠베르크의 '불확정성의 원리(Uncertainty Principle)'가 '기계(Machine)'의 '불완전함'을 증명해 줄 것으로 믿고 있다.

2-3. '물리학 법칙'은 로봇을 제작하는데 걸림돌이 되지 않는다.

하지만 대부분의 물리학자와 공학자들은 '물리학의 법칙'이 완전한 로봇을 제작하는 데 걸림돌이 되지 않는다고 믿고 있다. 수학자이자 '정보이론의 아버지'로 불리는 '클로드 섀넌(Claude Shannon, 1916~2001)'은 '기계가 생각할 수 있습니까?'라는 질문에 '물론이죠!(Sure!)'라고 대답했다. 그 이유를 묻자 그는 "저도 생각하고 있지 않습니까?"라고 대답했다. 즉, 그는 인간이라는 존재 자체가 이미 '기계(Machine)'이기 때문에 기계도 생각할 수 있다고 대답한 것이다.

3. 지능에 대한 정의

우리는 지능이 무엇인지 정확하게 정의할 수 있을까? 사실 지능에 대한 명백한 정의는 내려져 있지 않다. AI 연구자 사이에서조차 지능의 정의에 대해 아무런 동의가 이뤄져 있지 않다. 하지만 여러 전문가들의 통일되지 않은 의견을 모두 포괄할 수 있을 정도로 아주 넓게 정의를 내려본다면 '복잡한 목표를 달성하는 능력' 정도로 생각해볼 수 있다.

여기에서 목표에 포함되는 것은 매우 많기 때문에, 지능의 종류도 그만큼 많다고 볼 수 있을 것이다. 따라서 IQ처럼 숫자 하나로 지능을 계량하는 행위는 그다지 적절하지 못하다. 예컨대 '알파고(AlphaGo)'와 이세돌의 지능을 단순 비교하는 것은 큰 의미가 없다고 보는 것이다. 물론 바둑에서만큼은 이세돌보다 알파고가 지능적이라고 말할 수 있겠지만, 알파고는 다양한 목표를 수행하지는 못하므로 넓은 의미에서 인간보다 지능적이라고 말할 수 는 없다.

4. AI 연구의 가장 큰 목표는 '범용 AI'

사실 알파고처럼 특정 한 분야 혹은 좁은 분야에서 있어서는, 이미 기계가 인간의 지능을 추월한 분야가 꽤 많다. 하지만 인간의 지능은 굉장히 광범위한 범위에서 기계의 지능을 여전히 압도한다. 따라서 앞으로 AI의 연구의 가장 큰 목표는 복잡한 어떤 목표든 이룰 수 있는 '범용 AI'를 만드는 일이 되어야 할 것이다. 정리하자면, 인공지능의 발전의 핵심은 얼마나 자유도가 높은 문제를 푸는가에 달려있다.

인공지능은 1997년 당시 바둑보다 훨씬 경우의 수가 적은 체스에서 세계 챔피언을 이겼고, 2016년에는 체스보다 경우의 수가 많은 바둑에서 이세돌을 이겼다. 그리고 가장 자유도가 높은 환경은 바로 우리가 살고 있는 현실이다. 이처럼 인공지능은 점점 더 자유도가 높은 환경에서 문제들을 해결하면서 지속적으로 발전되었다.

AI의 발전이 계속되어 계산, 번역, 운전, 바둑, '투자(Investment)', '프로그래밍(Programming)', '경영(Management)', '예술(Art)'같은 다양한 목표에서 AI가 하나씩 사람 수준의 지능을 갖추다 보면, AI의 발전은 일종의 '티핑 포인트(Tipping Point)'에 다다를 것이다. 그 '티핑 포인트'로 여겨지는 수위는 기계가 'AI 설계'를 수행할 능력을 갖추는 단계에 해당된다. 티핑 포인트에 도달하면 기계는 기계를 스스로 개선하기 시작할 것이고 그 속도는 점점 빨라져서 현실 세계의 모든 분야를 빠르게 잠식할 것이다. 이것이 바로 '지능 폭발(Intelligence Explosion)'이다.

5. 지능의 특성

지능은 궁극적으로 물질이 아니라, 정보가 저장되고 연산되고 학습되는 과정이다. 따라서 어떠한 '기질(Substrate)'이 지능의 특성인 '기억(Memory)', '연산(Operation), '학습(Learning)'이 가능하다면 그 기질이 탄소기반이 아니더라도 지능을 가질 수 있는 것이다. 지능의 특성인 '기억(Memory)', '연산(Operation), '학습(Learning)'이 가능하다면 물질도 지능을 가질 수 있을 것이다.

5-1. 기억

'기억(Memory)'은 정보의 저장이다. 우리는 정보를 저장하기 위해 책, 뇌, 하드 드라이브 등을 이용하고 있다. 이처럼 저장 장치로써 쓰이기 위해서는, 어떤 물질이든 안정한 상태를 띨 수 있으면 정보가 저장되는 기질이 될 수 있다. 컴퓨터의 경우, 정보가 0과 1 두 가지 상태로만 입력된다. 때문에 안정적이면서도 비트(bit)를 읽고 쓰기 쉽다. 그래서 컴퓨터를 사용하다 보면, 컴퓨터의 기억장치에 저장되어 있던 정보가 무선 네트워크의 전파, 광섬유의 레이저 펄스, 종이의 입자 등으로 바뀌는 일이 많다. 이것은 정보가 어떤 물리적 형태로 저장되는지는 그다지 중요하지 않다는 것을 의미한다. 이처럼 정보는 '기질(Substrate)'로부터 독립된 생명을 가지고 있다고 볼 수 있는데 우리는 이러한 특성을 '기질 독립성'이라고 부른다.

5-2. 연산

'연산(Operation)'이란 기억된 상태를 '함수(Function)'를 시행하여 다른 상태로 변환하는 일이다. 어떤 물질로 된 기계가 고도로 복잡한 함수를 시행할 수 있다면 고도로 복잡한 목표를 성취할 수 있다. 따라서 우리는 물질로 된 기계가 어떻게 고도로 복잡한 함수를 수행할 수 있을지를 고민하면 되는 것이다.

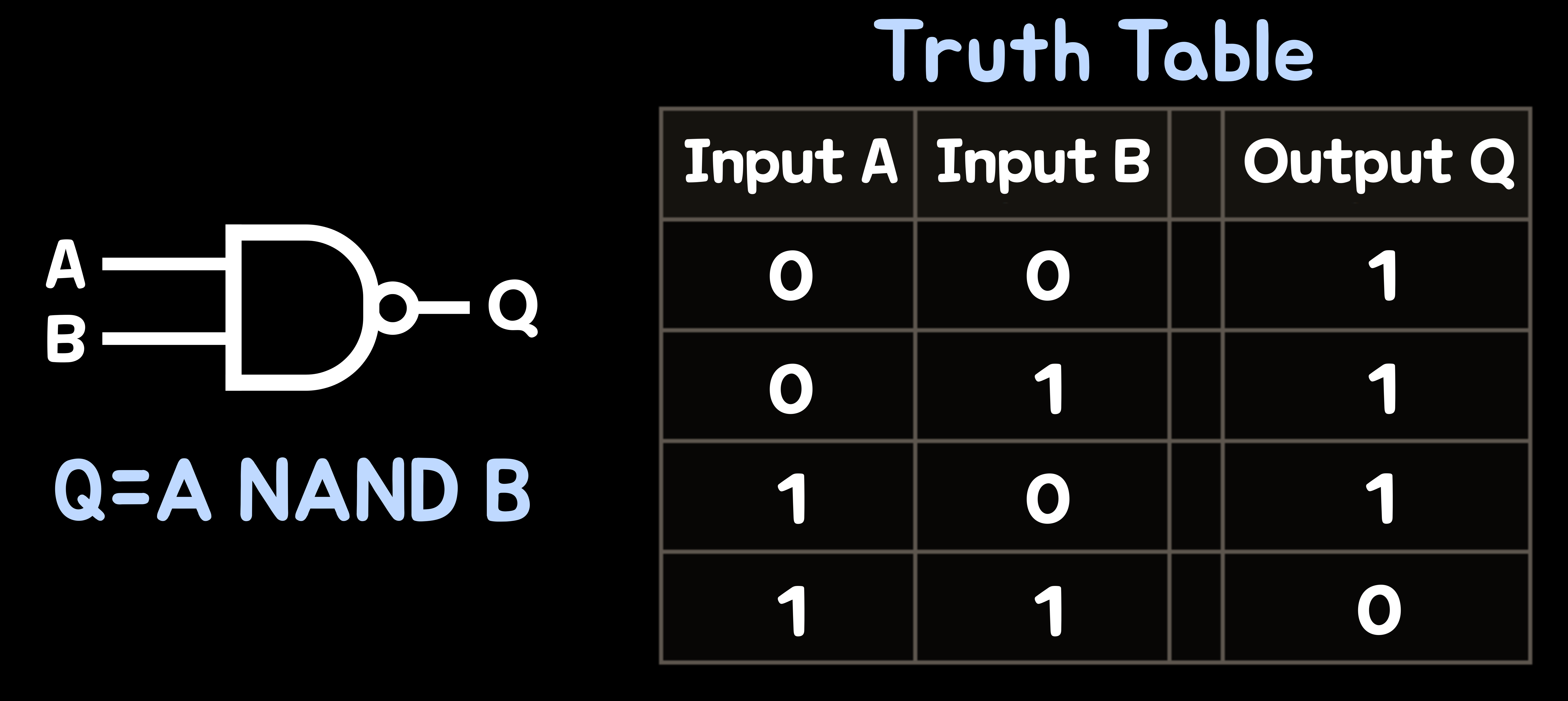

컴퓨터 과학에서 사용되는 기본 단위의 함수 중에는 '낸드 게이트(NAND Gate)'라는 함수가 있다. 이는 논리 회로를 구성하는 함수로 두 개의 입력값이 모두 1일 경우 출력값이 0이 나오고 다른 경우의 입력값의 경우 출력값이 1이 나오게 된다. 그런데 '낸드 게이트'같은 기본 단위의 함수를 충분히 만들 수 있다면 이를 잘 구성하여 어떠한 연산도 가능한 함수를 만들 수 있다. 우리는 이처럼 뜻대로 연산을 수행할 수 있는 기질을 '컴퓨트로늄(Computeronium)'이라고 부른다. 우리는 방금 극도로 복잡한 '컴퓨트로늄'을 만드는 것이 특별히 어렵지 않다는 사실을 확인하였다.

5-3.학습

우리는 지금까지 물질이 기억하고 연산할 수 있다는 것을 확인하였다. 복잡한 목표를 달성하는 일은 함수를 통해 가능하다는 것을 알게 되었고 적절히 배열된 물질은 어떠한 연산도 가능하다는 것을 알게 되었다. 그렇다면 기계는 지능의 특성중 하나인 학습도 가능할까?

'물질(Matter)'이 무엇을 배우려면, 물리 법칙 내에서 바람직한 '함수(Function)'를 계산하기 위해 스스로 더 나은 물리적 재배열이 가능해야 한다. 우리 뇌에는 약 1000억 개의 뉴런이 있고, 각각의 뉴런은 서로 영향을 미치는 약 1000개의 뉴런에 연결되어 있다. 이 뉴런들은 어느 두 뉴런이 활발해지는 일이 잦으면 물리학 법칙에 따라 시냅스 연결이 강화되는 등 뇌세포와 뇌 부위가 유동적으로 변하면서 학습이 된다. 이러한 특징을 '신경 가소성(Neuroplasticity)'이라고 부른다. 이런 '신경 가소성' 덕분에 뇌 속의 신경망은 학습을 위한 강력한 기질이 될 수 있었던 것이다.

이 신경망에서 힌트를 얻은 컴퓨터 과학자들은 학습이 가능한 기계 지능을 만들기 위해 '신경망 모델(Neural Network Model)'을 만들었다. 이것이 바로 '딥 러닝(Deep Learning)'이다. 놀랍게도 뉴런을 극도로 단순화시킨 모델이었음에도 불구하고 신경망 프로그램은 인간 수준의 학습 성과를 달성할 수 있었다. 결국 신경망 프로그램은 학습이 가능한 인공지능의 능력을 혁명적으로 향상시킬 수 있었다.